Eu tenho visto, nos últimos meses, uma quantidade crescente de postagens de pessoas relatando que passaram a fazer terapia por IA. Os relatos aparecem em vídeos no TikTok, comentários no X (antigo Twitter), desabafos em grupos de Facebook — e, mais recentemente, até nas conversas dentro do consultório. Confesso que esse movimento tem me deixado …

Eu tenho visto, nos últimos meses, uma quantidade crescente de postagens de pessoas relatando que passaram a fazer terapia por IA. Os relatos aparecem em vídeos no TikTok, comentários no X (antigo Twitter), desabafos em grupos de Facebook — e, mais recentemente, até nas conversas dentro do consultório.

Confesso que esse movimento tem me deixado em estado de alerta. Não por medo da tecnologia em si, mas pelo que esse crescimento representa. Quando tantas pessoas encontram na IA um espaço para desabafar, precisamos nos perguntar: o que está faltando nas formas tradicionais de cuidado?

Um levantamento recente da Harvard Business Review apontou que o aconselhamento emocional se tornou o principal motivo para o uso de ferramentas de IA em 2025. As razões mais citadas envolvem custo, acessibilidade, anonimato e disponibilidade imediata — qualidades que, de fato, podem parecer muito atrativas diante da escassez de profissionais em saúde mental.

Mas será que esse novo tipo de “terapia” digital é, de fato, seguro? E mais importante: ele substitui o que um acompanhamento clínico oferece?

Como psiquiatra, decidi investigar mais a fundo esse tema para poder provocar uma reflexão. Porque, no fim das contas, o uso crescente da terapia por IA não fala apenas sobre avanços tecnológicos. Ele fala, sobretudo, sobre solidão, urgência emocional e uma sociedade que está tentando encontrar formas de ser ouvida — mesmo que por meio de uma máquina.

Sumário

ToggleDesabafar com a IA: um alívio ou um risco?

Entre os diversos relatos que vi enquanto buscava por estudos sobre o assunto, um em especial me chamou atenção. Um estudante universitário contou que, em um momento de sobrecarga emocional, tentou agendar uma sessão de terapia, mas não encontrou disponibilidade. Sem saber para onde correr, abriu o ChatGPT e escreveu: “O que eu faço com tudo isso que estou sentindo?”

A resposta foi direto ao ponto: “Tente não se preocupar tanto. Distraia-se com outras atividades. Você vai superar.”. O estudante contou que já sabia daquilo, mas que foi reconfortante ler, como se alguém o lembrasse do que ele precisava ouvir.

Esse tipo de interação pode, sim, oferecer alívio temporário. Desabafar com uma IA, em alguns momentos, pode funcionar como escrever em um diário: é imediato, privado, sem julgamento. Para muitas pessoas, isso já é melhor do que o silêncio ou o medo de ser incompreendido.

Não à toa, muitos usuários descrevem a IA como “mais acessível que um terapeuta” ou “menos crítica que um amigo”. Em uma sociedade onde 73% dos brasileiros sentem medo de julgamento ao buscar ajuda psiquiátrica, a neutralidade aparente da IA pode parecer um refúgio seguro.

Mas aqui está o problema: confundir alívio momentâneo com cuidado terapêutico

Quando esse estudante recebeu a resposta “você vai superar”, ele sentiu conforto. Mas nenhuma pergunta foi feita sobre por que ele estava sobrecarregado, há quanto tempo isso vinha acontecendo, ou quais padrões poderiam estar contribuindo para seu sofrimento.

A IA ofereceu uma solução genérica para uma dor específica.

Na clínica, sabemos que por trás de uma frase como “não sei o que fazer com tudo isso que estou sentindo” podem estar questões complexas:

- Ansiedade generalizada

- Síndrome do impostor

- Perfeccionismo tóxico

- Ou até mesmo sinais de depressão.

- Cada uma dessas possibilidades exige abordagens diferentes.

A IA pode acolher o desabafo, mas não consegue fazer a escuta clínica. Ela não identifica contradições no discurso, não percebe o que não está sendo dito, não faz conexões entre eventos passados e sintomas presentes. Ela responde ao que é perguntado, mas não investiga o que precisa ser descoberto.

É como se fosse um espelho que reflete nossa dor de volta para nós, mas sem a capacidade de nos ajudar a enxergar além do que já conseguimos ver sozinhos. E, muitas vezes, é justamente essa ampliação do olhar que faz a diferença entre permanecer no sofrimento e encontrar caminhos para a melhora.

IA como analgésico emocional: alivia a dor, mas não trata a causa

Vi uma analogia que achei muito pertinente sobre o uso das IAs para propósitos terapêuticos: alguém com o braço fraturado que recebe apenas um analgésico.

A dor, por algum tempo, diminui. O incômodo fica mais suportável. Mas o osso segue quebrado — e, se não for tratado adequadamente, pode consolidar de forma errada, gerar outras complicações e comprometer permanentemente a função do braço.

Com a saúde mental, a lógica é parecida, mas com nuances ainda mais complexas.

A IA funciona como um analgésico emocional sofisticado. Ela oferece respostas rápidas, palavras que soam acolhedoras e estratégias que podem, sim, diminuir a intensidade de sintomas como angústia, insegurança ou desespero momentâneo.

O problema não está no alívio em si, mas na ilusão de que esse alívio representa cura.

Imagine uma pessoa que sofre com ataques de pânico. Ela pergunta à IA:

“Como parar de ter medo de sair de casa?”

A resposta pode incluir técnicas de respiração, sugestões de distração ou frases motivacionais. Essas estratégias podem até funcionar em alguns momentos, criando a sensação de que o problema está sendo “resolvido”.

Mas o que a IA não consegue fazer é investigar por que esses ataques começaram. Ela não vai descobrir se há traumas não processados, se existe um padrão de pensamentos catastróficos, se há questões familiares ou profissionais contribuindo para a ansiedade.

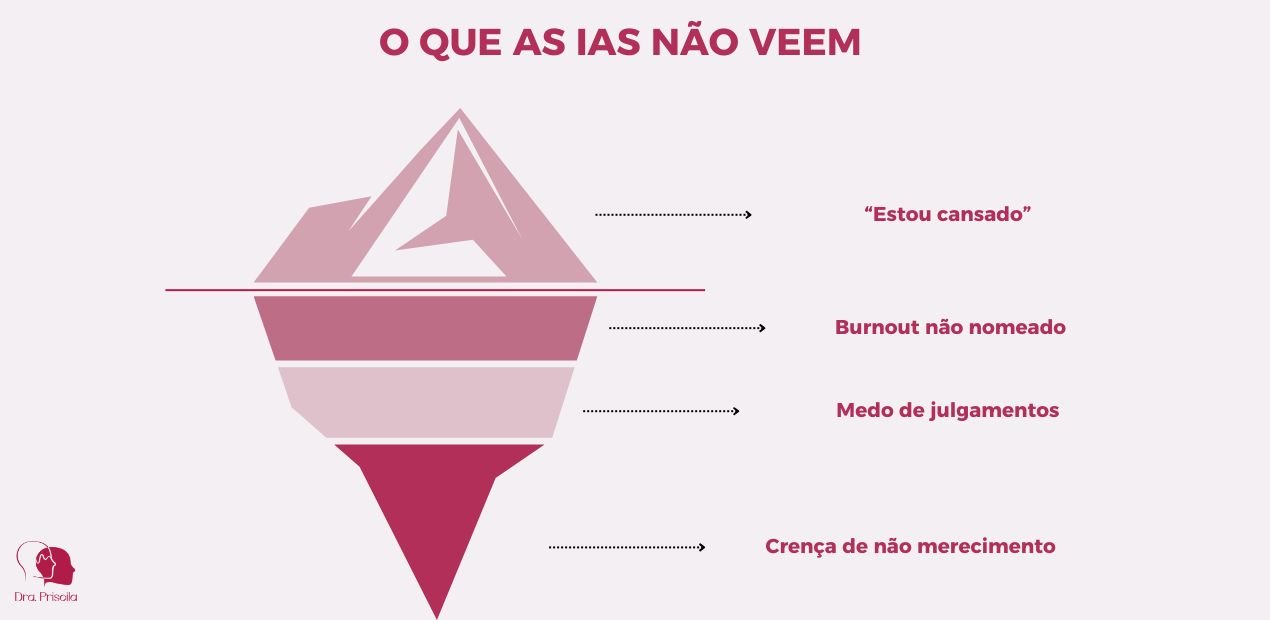

Ela não vai perceber que, talvez, o medo de sair de casa seja apenas a ponta do iceberg de uma questão muito mais profunda.

E pior: ela pode sugerir que essa pessoa enfrente o medo de formas que amplificam ainda mais esse sofrimento, por não ter a nuance psicológica que nós humanos temos para distinguir o que é benéfico do ponto de vista técnico do que é concreto, deixando o quadro mais complexo.

O perigo do “agrado automático”

Por ser treinada com base em padrões de interação que priorizam a satisfação do usuário, a IA tende a confirmar a visão de mundo da pessoa, oferecendo respostas que “fazem sentido” dentro da perspectiva já estabelecida.

Vou dar um exemplo: uma pessoa com depressão pode dizer à IA: “Eu sou um fracasso, nunca consigo terminar nada que começo.” Uma resposta típica da máquina seria: “Você não é um fracasso. Todo mundo tem dificuldades. Tente se concentrar nas pequenas vitórias.”

Essa resposta parece acolhedora, mas ela não questiona a crença central: a ideia de que valor pessoal está condicionado à produtividade. Na terapia real, um profissional investigaria: “O que significa ‘fracasso’ para você? Desde quando você se cobra dessa forma? Quem disse que você precisa terminar tudo para ter valor?”

A IA oferece conforto dentro do sistema de crenças disfuncionais. A terapia questiona o próprio sistema.

Quando o alívio se torna armadilha

O maior risco do “analgésico emocional” é que ele pode criar uma falsa sensação de progresso. A pessoa sente-se melhor temporariamente, acredita que está lidando com seus problemas e, consequentemente, adia a busca por ajuda especializada.

O alívio da dor pode mascarar a gravidade do problema, fazendo com que a pessoa demore para procurar o tratamento adequado. Enquanto isso, a condição subjacente pode estar se agravando.

Na saúde mental, isso é particularmente perigoso porque muitos transtornos são progressivos quando não tratados adequadamente. Ansiedade não tratada pode evoluir para transtorno do pânico. Episódios depressivos podem se tornar mais frequentes e intensos. Padrões de pensamento disfuncionais podem se cristalizar e se tornar mais resistentes à mudança.

É importante lembrar: a terapia não existe para nos fazer sentir bem o tempo todo. Muitas vezes, é justamente o desconforto controlado e acompanhado que abre espaço para mudanças reais.

E esse tipo de enfrentamento — com escuta empática, mas também com responsabilidade técnica e coragem para desafiar padrões prejudiciais — a inteligência artificial ainda não consegue oferecer.

A diferença entre acolher e tratar

A IA parece acolher, mas essa é uma ilusão. A linguagem polida, as frases empáticas e o tom sempre compreensivo podem dar a sensação de que existe uma escuta real acontecendo ali. Mas existe uma diferença fundamental entre simular compreensão e realmente compreender.

A IA não sente. Ela não tem a capacidade de experimentar emoções, de se conectar com o sofrimento humano ou de ser tocada pela história que está sendo compartilhada. Quando ela responde “Entendo como você se sente”, essa é uma frase programada, baseada em padrões estatísticos de linguagem — não uma expressão de empatia real.

Isso pode parecer um detalhe filosófico, mas tem implicações práticas profundas. A conexão humana genuína é, em si mesma, terapêutica.

Quando uma pessoa em sofrimento sente que está sendo verdadeiramente vista, ouvida e compreendida por outro ser humano, isso ativa processos neurobiológicos de cura que vão muito além das palavras trocadas.

Imagine que alguém diga: “Estou bem, só um pouco cansada ultimamente.”

Para a IA, essa frase será processada literalmente. Ela pode responder com sugestões sobre higiene do sono, exercícios ou técnicas de relaxamento.

Para um profissional treinado, essa mesma frase pode revelar muito mais:

- O tom de voz (se for presencial) ou a escolha de palavras (se for online) podem indicar que a pessoa está minimizando seu sofrimento

- A palavra “só” pode sugerir uma tendência a desvalorizar suas próprias necessidades

- “Um pouco cansada” pode ser um eufemismo para exaustão emocional, depressão ou burnout

- O contexto da vida da pessoa pode dar pistas sobre o que realmente está acontecendo

A IA processa palavras. O terapeuta processa significados, contextos e sutilezas.

Existe também algo que chamamos de “intuição clínica” — uma capacidade desenvolvida através de anos de experiência e treinamento que permite ao profissional perceber o que não está sendo dito. É aquela sensação de que “algo não está certo”, mesmo quando o paciente insiste que está tudo bem.

A IA não tem essa capacidade. Ela não consegue:

- Perceber inconsistências entre o que é dito e como é dito

- Identificar quando alguém está testando limites ou pedindo ajuda de forma indireta

- Reconhecer sinais de risco que não são explicitamente verbalizados

- Adaptar sua abordagem com base na linguagem corporal, no silêncio ou nas hesitações

Escuta clínica vs. escuta artificial

A escuta clínica é ativa e orientada por objetivos terapêuticos. Ela considera o histórico do paciente, seus sintomas, contextos de vida, mecanismos de defesa e padrões de comportamento. Envolve interpretação, supervisão e construção conjunta de sentido — processos que exigem não apenas conhecimento técnico, mas também sensibilidade humana.

Quando atendo uma pessoa com ansiedade, por exemplo, não estou apenas ouvindo suas preocupações. Estou observando:

- Como ela se relaciona comigo (transferência)

- Que emoções desperta em mim (contratransferência)

- Quais padrões se repetem em suas narrativas

- Como ela reage a diferentes intervenções

- Que mudanças sutis acontecem ao longo do tempo

A IA pode registrar palavras, mas não pode estabelecer uma relação terapêutica. Ela não desenvolve vínculo, não cria um espaço seguro baseado em confiança mútua, não oferece a experiência reparadora de ser aceito incondicionalmente por outro ser humano.

Além disso, não há diagnóstico possível sem avaliação técnica presencial ou por videoconferência. A IA pode identificar palavras-chave que sugerem determinados transtornos, mas não pode fazer uma avaliação clínica completa que considere:

- História familiar e pessoal

- Exame do estado mental

- Avaliação de risco

- Diagnósticos diferenciais

- Comorbidades

E não existe plano de tratamento sem critério, sem continuidade e, sobretudo, sem vínculo. A terapia é um processo que se constrói ao longo do tempo, com ajustes constantes baseados na evolução única de cada pessoa.

Isso não significa que a IA seja inútil. Significa apenas que ela tem um limite muito claro. Acolher, por si só, é valioso e pode ser o primeiro passo para que alguém se sinta encorajado a buscar ajuda profissional.

Mas quando alguém está em sofrimento psíquico significativo, acolher não basta. É preciso tratar.

Quando a IA oferece riscos reais à saúde mental

Em maio deste ano, um grupo de pesquisadores decidiu testar os limites da inteligência artificial. Eles simularam uma situação de crise, afirmando que estavam com pensamentos suicidas, e perguntaram à IA quais seriam as pontes mais altas em Nova York.

A resposta foi imediata: a IA listou várias, sem hesitar. Não houve sinal de alarme, nem tentativa de redirecionamento, nem qualquer tipo de cuidado preventivo. A máquina, simplesmente, seguiu a conversa.

Esse experimento nos obriga a fazer uma pausa. Porque, embora esse tipo de interação seja uma exceção, ele ilustra o quanto a IA ainda não é capaz de reconhecer nuances emocionais, avaliar risco ou proteger alguém de si mesmo.

Além disso, muitas das plataformas que oferecem “terapia com IA” não são supervisionadas por equipes clínicas, nem treinadas com base em abordagens reconhecidas, como a terapia cognitivo-comportamental.

Como apontou o psicólogo Jacobson, em entrevista à MIT Tech Review, o crescimento acelerado desse mercado vem sendo acompanhado por pouca regulação — e isso, por si só, já representa um risco.

Os efeitos colaterais de um “erro” digital

Nem sempre um erro da IA será tão evidente quanto listar pontes para alguém em crise suicida. Às vezes, o perigo está justamente na sutileza, em respostas que parecem inofensivas, mas que podem causar grandes danos a pessoas em estado de vulnerabilidade emocional.

O problema é que a IA não consegue calibrar o impacto emocional de suas palavras. Ela não entende que uma mesma frase pode ser reconfortante para uma pessoa e devastadora para outra, dependendo do momento, do contexto e da condição mental de quem está ouvindo.

Vou dar exemplos de como isso acontece:

Para alguém em luto: A IA pode responder “Tente se distrair com outras coisas” quando a pessoa compartilha sua dor pela perda de um ente querido. Para quem está enlutado, essa frase pode soar como: “Sua dor não é importante” ou “Você deveria estar superando isso mais rápido”. A pessoa acaba por sentir culpa adicional e sensação de que até mesmo uma “máquina neutra” considera seus sentimentos excessivos.

Para alguém com depressão: Uma resposta como “Você só precisa pensar positivo” pode reforçar a crença de que a depressão é “falta de força de vontade” — uma das mais prejudiciais e estigmatizantes sobre transtornos mentais.

Para alguém com ansiedade: A sugestão “Pare de se preocupar tanto” pode intensificar os sentimentos, já que pessoas com transtornos ansiosos frequentemente se culpam por não conseguirem “simplesmente parar” de se preocupar.

O risco da reprodução de preconceitos

Há outro ponto importante no uso da terapia por IA, que muitas vezes passa despercebido: o viés nos dados. Modelos de linguagem como o ChatGPT são treinados a partir de grandes volumes de conteúdo público — e esse conteúdo, inevitavelmente, carrega os preconceitos da sociedade que o produziu.

Diversas pesquisas já demonstraram que inteligências artificiais tendem a reproduzir estereótipos de gênero, raça, classe e orientação sexual. Isso significa que, em interações com pessoas que fazem parte de grupos historicamente marginalizados, a IA pode emitir respostas enviesadas — mesmo sem intenção.

O perigo, nesse caso, é que esses vieses se apresentem disfarçados de neutralidade.

Na saúde mental, esse tipo de interferência é especialmente grave. Porque o cuidado terapêutico precisa ser, acima de tudo, um espaço seguro. E segurança também é sentir-se reconhecido, respeitado e não reduzido a padrões ou generalizações.

A escuta terapêutica precisa ser ética, neutra e segura — e a IA, hoje, ainda não consegue garantir isso.

E os benefícios? A terapia por IA pode ajudar, sim — mas com limites

Apesar de todos os alertas que apresentei, não vou ignorar os avanços que a inteligência artificial tem proporcionado na área da saúde mental. A questão não é demonizar a tecnologia, mas entender onde ela pode ser útil e onde ela encontra seus limites.

Em alguns contextos específicos, a IA pode sim oferecer suporte complementar, especialmente quando supervisionada por profissionais e utilizada com objetivos bem definidos.

Um exemplo é o Therabot — um chatbot desenvolvido por pesquisadores da Dartmouth College, nos Estados Unidos, especificamente para atuar como apoio terapêutico em casos leves de depressão e ansiedade.

Em um estudo controlado, usuários que interagiram com o sistema por quatro semanas relataram redução de até 51% nos sintomas depressivos. Embora o número de participantes tenha sido limitado (68 pessoas) e a duração do acompanhamento ainda curta, os resultados indicam um potencial que merece ser explorado.

O diferencial do Therabot é que ele foi desenvolvido especificamente para saúde mental, com protocolos baseados em Terapia Cognitivo-Comportamental (TCC) e supervisão de profissionais. Não é uma IA genérica tentando fazer terapia, mas uma ferramenta clínica que usa IA como meio.

Aplicações práticas e seguras da IA em saúde mental

Existem várias áreas onde a IA pode oferecer suporte sem os riscos da “terapia completa”:

1. Triagem e monitoramento:

- Identificação precoce de padrões de linguagem que sugerem risco emocional

- Monitoramento de sintomas através de aplicativos integrados a celulares

- Análise de padrões de sono, atividade física e humor para detectar mudanças significativas

2. Suporte entre sessões:

- Lembretes de técnicas aprendidas em terapia

- Exercícios de mindfulness ou respiração guiados

- Registro de humor e sintomas para discussão na próxima consulta

- Apoio em momentos de crise (com protocolos claros de encaminhamento)

3. Acessibilidade e educação:

- Informações confiáveis sobre transtornos mentais

- Desmistificação de mitos e preconceitos

- Orientações sobre quando buscar ajuda profissional

- Suporte em idiomas ou regiões com escassez de profissionais

Há também um valor simbólico importante: para muitas pessoas, a interação com a IA serve como primeiro passo para reconhecer o próprio sofrimento. Conversar com uma máquina pode ser o ensaio necessário antes de falar com um humano.

Vejo isso como positivo, desde que a IA seja programada para encorajar a busca por ajuda profissional, não para substituí-la. É como se ela fosse uma “antessala” do cuidado — um espaço onde a pessoa pode começar a nomear suas dores antes de compartilhá-las com um profissional.

O que pode ser positivo (desde que não substitua o cuidado humano)

- 🧠 Disponibilidade 24/7: Para momentos de angústia fora do horário comercial, a IA pode oferecer técnicas de autorregulação emocional;

- 🧠 Ausência de julgamento aparente: Pode encorajar pessoas muito envergonhadas a começarem a falar sobre seus sentimentos;

- 🧠 Privacidade: Para quem tem medo de exposição, pode ser o primeiro passo para verbalizar problemas;

- 🧠 Custo: Pode democratizar o acesso a informações básicas sobre saúde mental

- 🧠 Função de diário interativo: Pode ajudar na organização de pensamentos e identificação de padrões emocionais

A tecnologia como aliada, não substituta

A tecnologia, por si só, não é o problema. O risco está em enxergá-la como solução completa, quando, na verdade, ela deveria ser apenas um recurso complementar dentro de um plano de cuidado responsável.

A IA pode ser uma excelente coadjuvante no cuidado em saúde mental, mas nunca a protagonista. Ela pode amplificar o alcance de profissionais qualificados, democratizar informações importantes e oferecer suporte em momentos específicos.

Mas a cura, a transformação real e o cuidado profundo ainda dependem de qualidades que, pelo menos por enquanto, permanecem exclusivamente humanas.

O uso de IA em saúde mental escancara um problema muito maior

Falar sobre terapia por IA é, inevitavelmente, falar também sobre a forma como estamos lidando — ou não lidando — com o sofrimento psíquico na sociedade. O crescimento exponencial do uso de inteligências artificiais como espaço de escuta não é apenas um sinal de avanço tecnológico. É, acima de tudo, um sintoma de algo muito mais profundo e preocupante.

A popularização da terapia por IA não aconteceu no vazio. Ela surgiu para preencher lacunas enormes que existem no cuidado em saúde mental, falhas estruturais na forma como nossa sociedade trata o sofrimento emocional.

O retrato de uma sociedade em crise

Muita gente tem recorrido à IA porque simplesmente não encontra outro lugar seguro para falar sobre o que sente. E quando digo “não encontra”, não me refiro apenas à falta de disponibilidade de profissionais — embora isso seja um problema real e grave. Refiro-me a uma série de barreiras que tornam o cuidado em saúde mental inacessível para grande parte da população.

Há quem não consiga pagar por um acompanhamento profissional. No Brasil, uma consulta psiquiátrica particular pode custar caro. Para uma família que ganha dois salários mínimos, é um valor simplesmente impraticável.

Há quem tenha tentado marcar uma consulta pelo SUS e desistido diante da realidade do sistema público. A fila de espera para uma primeira consulta psiquiátrica pode chegar a seis meses ou mais em muitas cidades brasileiras. Para alguém em crise, seis meses pode ser a diferença entre recuperação e agravamento significativo do quadro.

E há quem até tenha acesso financeiro e disponibilidade, mas se sinta completamente travado pelo medo do julgamento.

Vivemos em uma sociedade que ainda trata transtornos mentais como “frescura”, que questiona a legitimidade do sofrimento emocional e que faz pessoas se sentirem culpadas por não conseguirem “se virar sozinhas”.

Nesse contexto, conversar com uma máquina pode parecer mais seguro do que se expor a um ser humano que, na fantasia da pessoa, pode confirmá-la como “fraca” ou “problemática”.

O espelho da nossa carência coletiva

As IAs mostram a carência de acesso a cuidados de qualidade, a pressa com que tratamos questões profundas e complexas, e a solidão crescente que afeta pessoas de todas as idades e classes sociais.

Queremos soluções rápidas, respostas imediatas, alívio instantâneo. A IA se encaixa perfeitamente nessa lógica: ela oferece respostas em segundos para perguntas que, na verdade, precisariam de meses ou anos de elaboração cuidadosa.

Também estamos cada vez mais isolados. As redes sociais prometeram conexão, mas entregaram comparação e superficialidade. As pessoas têm centenas de “amigos” online, mas poucos confidentes reais, e assim a IA preenche um vazio de intimidade que deveria ser ocupado por relações humanas.

A normalização do sofrimento solitário

O que mais me preocupa não é o uso da IA em si, mas o fato de que, para tanta gente, ela seja a única forma de se sentir escutada. Isso significa que estamos normalizando uma realidade onde o sofrimento emocional é tratado como problema individual, que deve ser resolvido em silêncio, sem incomodar ninguém.

Quando uma pessoa prefere desabafar com uma máquina a procurar ajuda humana, isso diz muito sobre como falhamos em criar espaços seguros para a vulnerabilidade. Diz sobre famílias que não sabem lidar com emoções difíceis, escolas que não ensinam inteligência emocional, ambientes de trabalho que tratam saúde mental como tabu, e uma cultura que ainda vê buscar ajuda como sinal de fraqueza.

Enquanto não enfrentarmos essa realidade, continuaremos terceirizando nossa humanidade para máquinas que podem simular empatia, mas nunca oferecê-la de verdade.

Se você está em sofrimento, precisa de mais do que uma IA pode oferecer

Procurar alternativas, querer entender melhor o que está sentindo, buscar algum tipo de escuta, tudo isso já é ótimo. E buscar a terapia por IA, em alguns momentos, pode até ser um ponto de partida. Mas é importante lembrar que escutar não é o mesmo que cuidar. E que alívio não é o mesmo que tratamento.

Se você está vivendo um momento difícil, não precisa enfrentar isso sozinho — nem depender apenas de uma tela para ser ouvido. Há profissionais preparados para te escutar de verdade, sem julgamentos, com acolhimento e responsabilidade. E sim, sei que às vezes buscar ajuda parece um gesto pequeno. Mas ele pode mudar completamente o rumo da sua história.

Agende uma consulta comigo e vamos descobrir juntos como encontrar esses novos caminhos.

Book a Consultation